课程介绍:

Transformer 模型是现代 NLP 中的事实标准。它们已经在很大程度上证明了自己是最具表现力、最强大的语言模型,一次又一次地击败了所有主要的基于语言的基准。

在本课程中,我们将学习您开始使用 Google AI 的 BERT 或 Facebook AI 的 DPR 等转换器模型构建尖端性能 NLP 应用程序所需的所有知识。

我们涵盖了几个关键的 NLP 框架,包括:

HuggingFace 的Transformers

TensorFlow 2

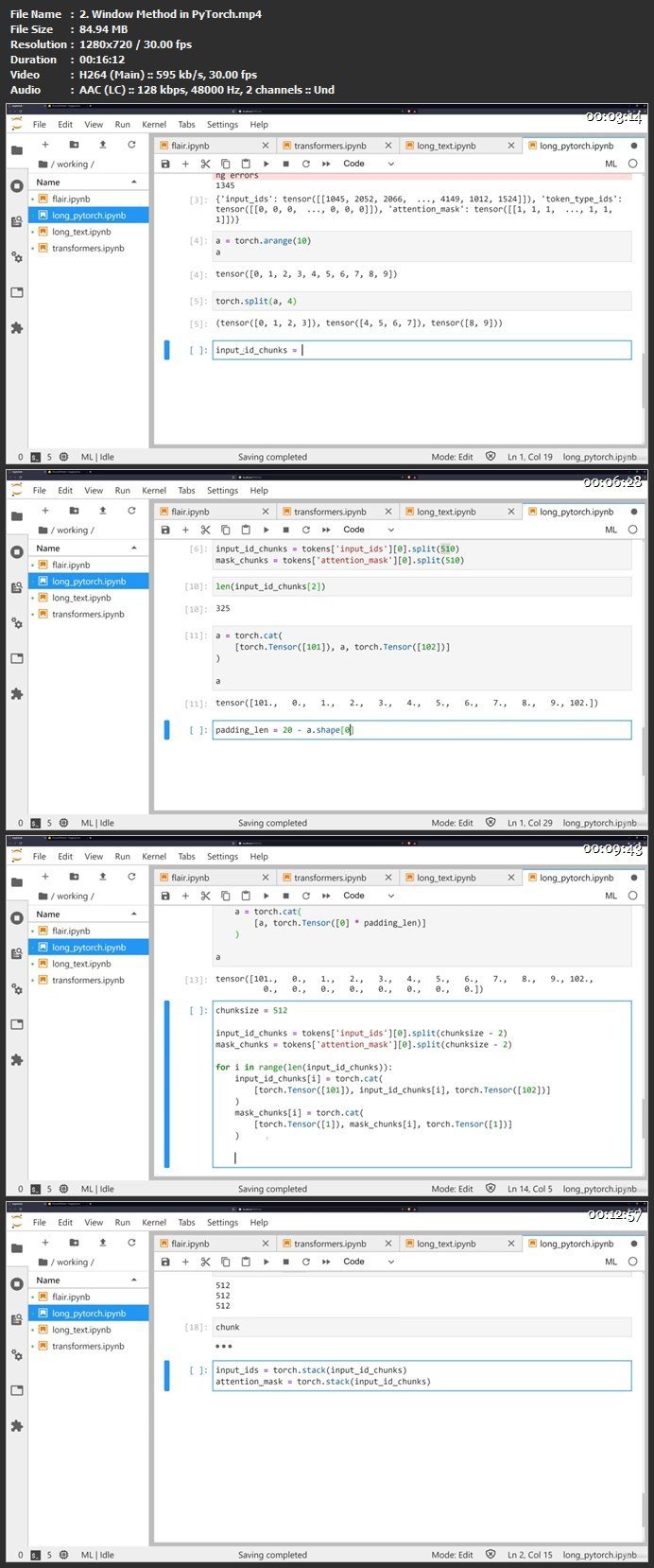

PyTorch

spaCy

NLTK

Flair

并了解如何将Transformers应用于一些最流行的 NLP 用例:

语言分类/情感分析

命名实体识别 (NER)

问答

相似性/比较学习

在所有这些用例中,我们都通过各种示例来确保Transformers是什么、如何以及为什么如此重要。除了这些部分,我们还完成了两个完整的 NLP 项目,一个用于金融 Reddit 数据的情感分析,另一个涵盖成熟的开放域问答应用程序。

所有这些都得到了其他几个部分的支持,这些部分鼓励我们学习如何更好地设计、实现和衡量我们模型的性能,例如:

NLP 的历史和 Transformer 的来源

NLP 常用的预处理技术

Transformer 背后的理论

如何微调Transformer

我们涵盖了所有这些以及更多内容,我期待在课程中见到您!

本课程面向的对象:

对 NLP 感兴趣的有抱负的数据科学家和 ML 工程师

希望提升技能的从业

者 希望实施 NLP 解决方案的开发人员

数据科学家

机器学习工程师

Python 开发人员

您将学到的内容

如何将 Transformer 模型用于 NLP

现代自然语言处理技术

NLP 近期发展概述

Python

机器学习

自然语言处理

Tensorflow

PyTorch

Transformers

情感分析

问答

命名实体识别

要求

Python

数据科学经验知识加

NLP 经验加

Duration: 11h 23m | Video: .MP4, 1280×720 30 fps | Audio: AAC, 44.1 kHz, 2ch | Size: 3.28 GB

Genre: eLearning | Language: English

Learn next-generation NLP with transformers using PyTorch, TensorFlow, and HuggingFace!

通过PyTorch、TensorFlow 和 HuggingFace 学习下一代 NLP Transformers模型!